亚马逊云科技上演了一场生成式 AI 能力的「王者归来」。

今天凌晨,有「云计算春晚」之称的 re:Invent 大会在美国拉斯维加斯开幕。亚马逊云科技一下子搬出了全新大模型 Nova 系列,性能比肩英伟达旗舰的 AI 训练芯片,与之对应的算力服务,并对 Amazon Bedrock 进行了一番从头到脚的升级。

登台演讲之前,亚马逊云科技新任 CEO Matt Garman 提出了一个发人深省的观点:人工智能是一场没有终点的竞赛,它将永远持续下去。

这场竞赛其实还处在开始阶段,经历了「All in 大模型」的疯狂之后,大家确实在思考:面对这场持久战,接下来要重点关注「细水长流」了。

对于各行各业的用户来说,可持续发展问题首先是成本问题。如果说去年的我们还在摸索如何适应新的生成式 AI 技术,那么到了 2024 年的末尾,更重要的是:如何持续降低生成式 AI 的应用成本,换言之,提升生成式 AI 技术应用的性价比。

在今天凌晨的 Keynote 中,Matt Garman 分享了亚马逊云科技在人工智能和计算等领域的「新技术、新产品、新服务」,生成式 AI 技术栈再次焕新。

我们看到了相当前沿的一波技术能力,源源不断地震撼发布。与此同时,技术落地成本降低到了难以置信的程度。

这一切升级,的确称得上「真正革命性的变化」。风云变幻的生成式 AI 时代,亚马逊云科技又一次「Hold 住全场」。

成本直降 75%

全模态 Amazon Nova 将「性价比」做到极致

去年 4 月,亚马逊云科技刚刚加入生成式 AI 大模型之战,发布的 Amazon Titan 系列模型当时仅支持文本内容生成和创建高效搜索。一年多过去,亚马逊云科技已经在基础模型层完成了全面的布局,向覆盖文本、图像、视频和语音的全模态体系发起冲击,在与 OpenAI、谷歌、Anthropic 等主流大模型厂商的竞争中,丝毫不落下风。

本次 re:Invent 大会上,全新自研生成式 AI 多模态 Amazon Nova 系列模型正式亮相,不仅在多种任务中达到了 SOTA 智能水平,更在性价比层面实现了业界领先。

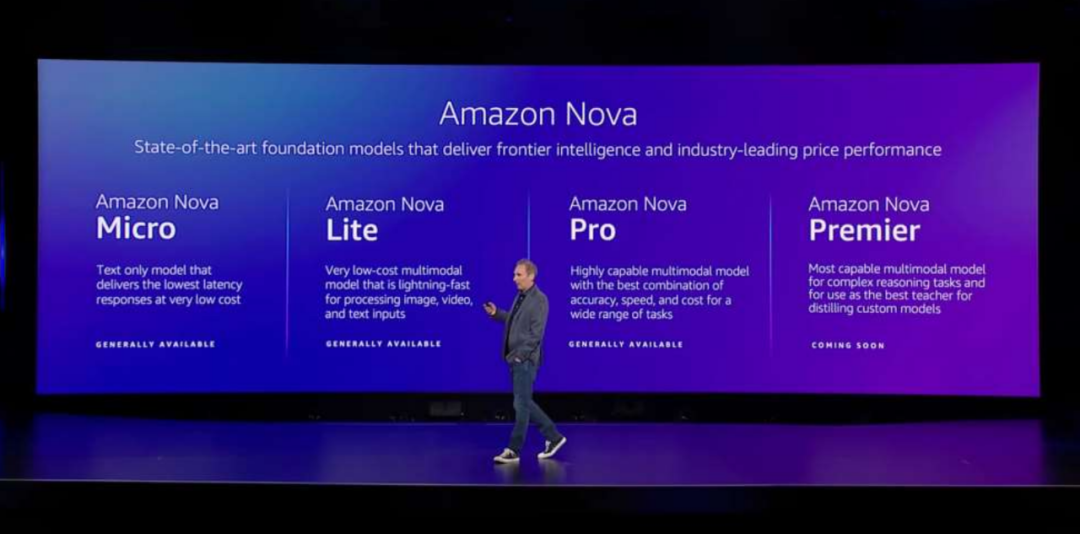

此次发布的 Amazon Nova 系列模型共四个版本:纯文本模型 Amazon Nova Micro,支持 128k 上下文,能够以极低成本实现最低延迟响应;成本极低的多模态模型 Amazon Nova Lite,支持 300k 上下文或 30 分钟视频输入,可以快速处理图像、视频和文本;功能强大的多模态模型 Amazon Nova Pro,同样支持 300k 上下文或 30 分钟视频输入,兼顾准确性、速度和成本,适用于各种任务;功能最强的多模态模型 Amazon Nova Premier,可用于复杂推理任务,并用作自定义蒸馏模型的最佳教师模型。

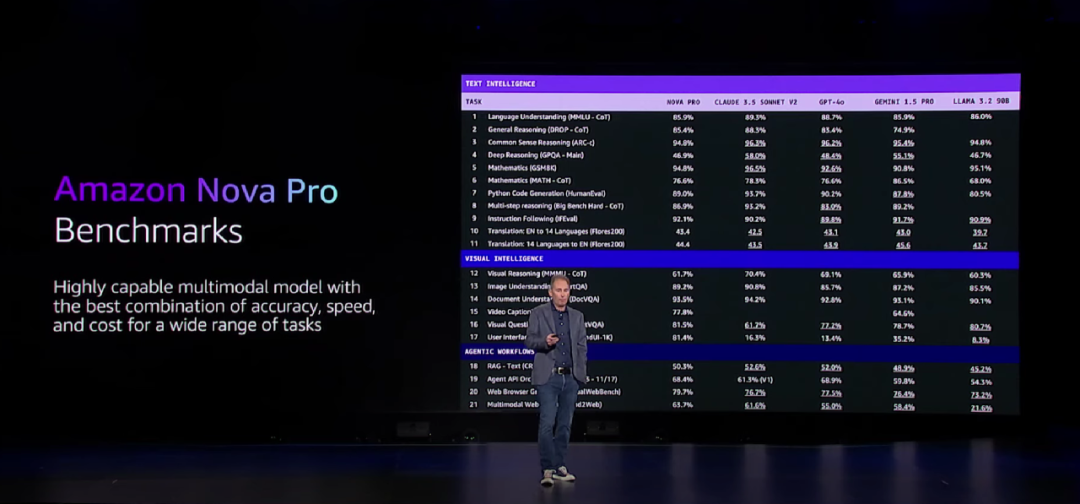

模型好不好,先跑个分。从打榜结果来看,Amazon Nova 系列模型经受住了各种行业基准测试,直接挑战了 GPT-4o、Gemini 1.5 Pro 和 Claude 3.5 Sonnet V2 这样的顶级选手。

Amazon Nova Pro 与 GPT-4o、Gemini 1.5 Pro 和 Claude 3.5 Sonnet V2 的比较。

一方面,纯文本 Amazon Nova Micro 在与 LLaMa 3.1 8B、Gemini 1.5 Flash-8B 的较量中取得了相当或者更优的表现。Micro 210 tokens/s 的输出速度实现了业界领先,对于需要快速响应的应用程序而言,Micro 是最佳选择。

另一方面,多模态 Amazon Nova Lite 和 Amazon Nova Pro 与 OpenAI、谷歌和 Anthropic 等主流厂商相比,在绝大多数基准上表现相当甚至更好。尤其在处理轻量级任务时,Lite 是当前成本最低的多模态模型。

目前,Amazon Nova Micro、Lite、Pro 三款模型均已推出,并集成到了 Amazon Bedrock 中,支持自定义微调和蒸馏。Amazon Nova Premier 则将于 2025 年第一季度问世。

在性能全方位加强之外,Amazon Nova 系列模型中 Micro、Lite 和 Pro 的价格至少比 Amazon Bedrock 中各个智能类别中的最强模型要便宜 75%。对于有大模型服务调用需求、预算不高但又不想在模型效果上打折扣的客户来说,Nova 系列无疑是一个性价比极高的选择。

另外,在图像和视频生成模型百花竞艳的当下,亚马逊云科技也秀了一把内容创作实力。独立的图像生成模型 Amazon Nova Canvas 和视频生成模型 Amazon Nova Reel 悉数登场:Canvas 支持图像生成和编辑,提供丰富的配色方案和布局控件;Reel 可根据关键提示词和参考图像生成 6 秒视频,支持用户调整摄像头运动以进行平移、360 旋转和缩放,未来还会支持 2 分钟视频生成。

提示词:一只狗在很开心地兜风。狗的嘴巴张开时要注意舌头的位置。

最后,安迪・贾西还预告了另外两款 Amazon Nova 模型,分别是 Amazon Nova Speech-to-Speech 和 Amazon Nova Any-to-Any。前者要实现自然、类人的口头交互,后者旨在用同一个模型解决多种任务,包括多模态转换、内容编辑以及 AI 智能体操作。这两款模型预计将先后于 2025 年第一季度和中期与大家见面。

从文本到视频的 Amazon Nova 模型一次性全部上线,下一步计划也直接对标最新方向。亚马逊云科技自研大模型的进化速度,着实让全场观众都震撼了一下。

自动蒸馏,多智能体协作,还能搞定 LLM 幻觉

Amazon Bedrock 又变强了

自生成式 AI 爆发两年多以来,亚马逊云科技的人工智能战略一直没有改变,那就是希望作为一个中立且有能力的平台,为企业、开发者们提供灵活的、领先的 AI 模型选择。

除了聚合一批顶尖模型,在工具层,亚马逊云科技也一直在确保用户能够拥有最先进的技术。

这次大会,亚马逊云科技基础模型托管服务 Amazon Bedrock 的更新直指企业用户当下急需的技术能力。

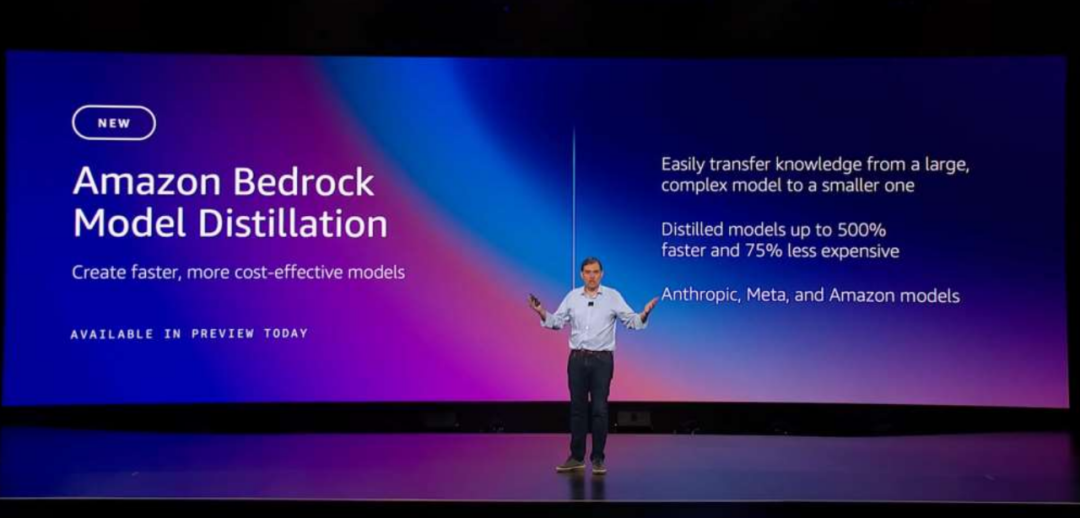

首先是帮助对大模型进行蒸馏的 Amazon Bedrock Model Distillation,它通过从大型基础模型(被称为教师模型)生成响应,并用生成结果来微调较小的基础模型(被称为学生模型),可以自动为特定用例创建优化版模型。

有了这项功能,用户可以快速构建实用化的生成式 AI 模型,并提高小模型的准确性,通过知识转移过程获得大体量模型的大部分能力,或是针对特定用例提炼专有模型。据亚马逊云科技介绍,经过优化的模型比原始大型模型快五倍,计算成本低 75%,对于检索增强生成 (RAG) 等用例,准确度损失不到 2%。

另外一项新推出的服务 Automated Reasoning checks,赋予用户通过自动推理减少大模型幻觉、检查提高对话式 AI 准确性。这意味着,可以通过交叉引用提供的信息来验证大模型响应是否准确,自动推理检查是消除幻觉的「第一个」也是「唯一」的保障。

具体来说,当大模型生成响应时,自动推理检查会对其进行验证,使用「逻辑准确」和「可验证的推理」得出结论。如果可能出现幻觉,则系统根据基本事实得出正确答案。该答案与可能的错误信息一起呈现,人们可以直观地看到模型偏离了多远。

基础模型之上,大模型领域的竞争已经升级到「智能体」(Agent)阶段,Anthropic、微软等公司纷纷推出了桌面级的智能体应用,它们大大扩展了大模型执行任务的范围,比如网购、发邮件、订票,就像是打通了大模型落地的最后一关。

亚马逊云科技同样加重了对 Agent 的投入。现在,Amazon Bedrock 已经上新了实现大模型多智能体协作的工具。

构建有效多智能体协作系统的关键在于管理大规模协调多个专业智能体的复杂性和开销。Amazon Bedrock 简化了其过程,帮助人们将复杂任务分解为多个子任务,利用专业 AI 能力进行解决,提高了多智能体协作框架在解决复杂的现实问题方面的协调能力、通信速度和整体有效性。

至此,我们能够很清晰地看出:Amazon Bedrock 的进化对应了用户在应用生成式 AI 过程中所面临的几大挑战 —— 大模型推理的算力需求、大模型的准确性,以及多智能体操作。

当技术飞速进化时,用户需求的变化速度往往超出需求。不过这些艰难的关卡,已经被 Amazon Bedrock 逐个击破了。

新一代 AI 芯片 Trainium 面世

算力革命正在路上

如果你需要运行科学计算或大型 AI 模型,那就需要大范围、低延迟的网络来连接所有 GPU 节点,亚马逊云科技可以提供迄今为止业内最快、最易扩展的算力。

十年来,AI 行业已经形成了一个共识:模型之所以能够实现参数量规模和计算复杂度的持续增长,得益于强大算力的支撑。

此前,我们可以从两个较为简单的维度来理解这个结论:要么向上扩展,使用更大的计算机;要么向外扩展,使用更多的计算机。

但在生成式 AI 时代,由于涉及数十亿甚至上千亿的参数,设计、训练和部署模型都需要消耗大量的计算资源。比如,每次训练都需要对海量数据进行复杂的矩阵运算和梯度计算,对算力基础设施的要求已不可同日而语。

对于想要应用生成式 AI 的企业来说,想要保持对 OpenAI、谷歌等顶尖公司的追赶,这意味着要购买越来越多的高端芯片和云服务,支出的计算成本因此显著上涨。Gartner 分析称,到 2025 年,随着 AI 技术基础设施的不断升级,各个云支出领域的增长率都将达到两位数。

现在,核心问题已经变成了:如何在算力资源供应短缺的大环境下扩大算力来源,以及如何在大模型产生高昂计算成本压力下极致高效地利用算力。

对于众多企业用户来说,亚马逊云科技的自研 AI 芯片提供了一个速度更快、能耗更低的优质选项。

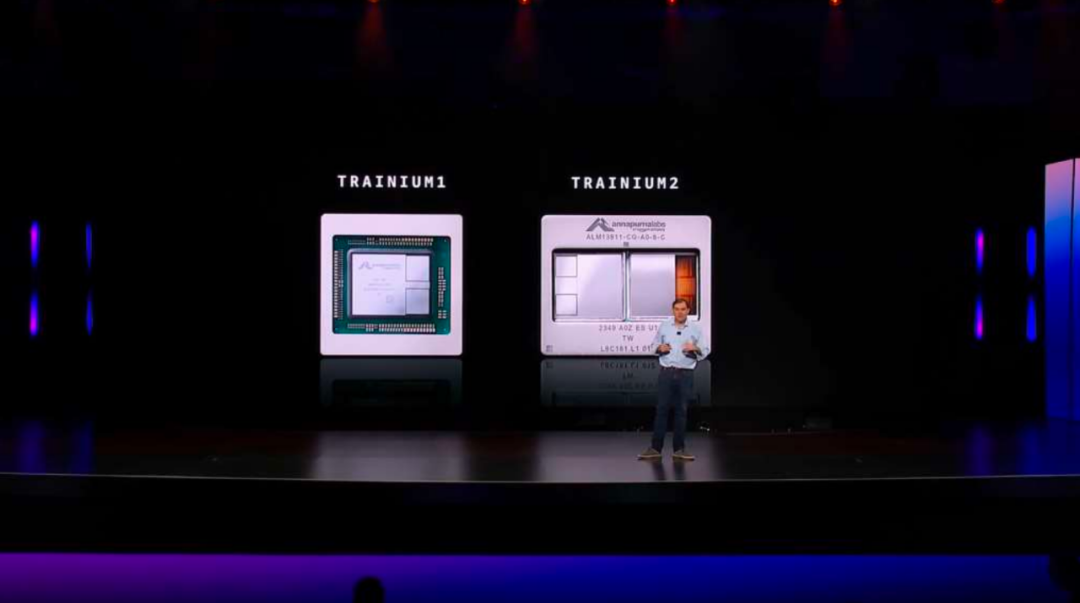

Trainium 是亚马逊云科技自研的 AI 芯片,2020 年首次推出,曾一度被认为是训练 AI 模型最具效率的芯片。

在这次的 re:Invent 大会上,亚马逊云科技宣布 Trainium2 芯片全面正式可用,帮助行业训练和部署大型语言模型。Trainium2 在一年前首次发布,速度是其上一代产品的四倍。

单个 Trainium2 驱动的 EC2 实例配有 16 个 Trainium2 芯片,可提供高达 20.8 PetaFLOPS 的计算性能。在测试中,与其他云服务商的类似产品相比,使用 Amazon Bedrock Trn2 EC2 实例的 Llama 3.1 405B 模型 token 生成吞吐量提高了三倍以上。

另一个非常值得关注的消息是:亚马逊云科技和 Anthropic 正在合作构建一个名为 Project Rainier 的 Trn2 UltraServer 集群。

生成式 AI 爆发后,Anthropic 就大量使用了亚马逊云科技的算力设施。在大模型赛道上,Anthropic 始终是对 OpenAI 追赶得最紧的一位玩家。今年 11 月底,亚马逊宣布向 Anthropic 追加 40 亿美元投资,这笔交易后,对 Anthropic 的投资总额达到 80 亿美元。基于深厚的合作关系,Anthropic 后续将用亚马逊云科技的 Trainium AI 芯片来训练和运行其 AI 模型。

Project Rainier 这个集群会包含数十万个 Trainium2 芯片,为 Anthropic 提供了足够的可扩展分布式计算能力训练下一代大模型。与 Anthropic 用于训练其当前一代模型的集群相比,新集群的计算能力达到其 5 倍,并将成为迄今为止全球最大的 AI 计算集群。

对于规模更大的万亿级参数 LLM,亚马逊发布了第二层 Trianium2 实例 Trn2 UltraServer,同时提供 64 个 Trainium2 芯片用于 AI 模型训练或推理。它将允许用户超越单个 Trn2 服务器的限制,可以提供高达 83.2 PetaFLOPS 峰值计算能力。

与此同时,亚马逊云科技的下一代自研 AI 芯片也在路上了:Trainium3 是这家科技公司第一款采用 3nm 工艺制造的芯片,将提供两倍于 Trainium2 的性能,能耗降低为 40%。它的性能将比肩英伟达的新一代 AI 芯片。

首批基于 Trainium3 的实例预计将于 2025 年上市。亚马逊云科技表示,搭载 Trainium3 的 UltraServer 预计性能会比搭载 Trainium2 芯片的 UltraServer 高出四倍。

在生成式 AI 技术突飞猛进的情况下,不断进化的亚马逊云科技为用户提供了一个安心的「算力」选项。当人们热议「追逐 Scaling Law 还有没有意义」的时候,至少不断进化的 Trainium 系列和亚马逊云科技长期以来构建的一整套 AI 基础设施,能让千行百业的用户在这场浪潮中找到「船桨」。

生成式 AI 走向应用的「底层逻辑」

此外,亚马逊云科技还在新版本的 Amazon SageMaker 上简化了数据和 AI 资产管理的功能,并为 Amazon Aurora 云数据库大幅提升了吞吐速度。

从新一代大模型,到开发工具、管理平台、芯片,再到数据处理模块。从今天的发布会上我们可以看出,亚马逊云科技一直在强调大模型全链路技术在新一代应用中将要起到的关键作用。

与让大模型学会新技能的「训练」相对应的是,推理是 AI 模型生成预测或输出的过程,代表着模型的应用。从行业角度看:随着 AI 技术的成熟,生成式 AI 的一次次推理最终会推动很多行业发生变革。而从技术的角度看:在开发者调用 AI 能力时,其背后从硬件到算法、应用,计算的全流程,仅仅优化两个字,却包含着无数的技术实践的努力。

在生成式 AI 技术落地的过程中,不断整合先进的 AI 能力,并将基础设施无缝集成,保证易于使用,是亚马逊云科技的目标。

亚马逊云科技正在全流程降低生成式 AI 构建的门槛。从某种层面上来说,如果 OpenAI 是在为大模型通向 AGI 探索方向,亚马逊云科技就是在为生成式 AI 技术应用落地铺路。

这其中的一系列工作,重要性不言而喻,而且和竞争者相比,亚马逊云科技已经全方位拉开了代差。

华为novaamazonAI亚马逊云科技

新浪科技公众号

新浪科技公众号 “掌”握科技鲜闻 (微信搜索techsina或扫描左侧二维码关注)

相关新闻

相关新闻